这个话题很大,严谨的研究需要我们把问题收回来,仅仅讨论一个小问题——我们发现绝大部分神经网络在测试样本上分类置信度可以解构成简单的符号化的交互逻辑,并且这样交互逻辑在不同样本和不同模型上还有一点的泛化性,我们将其视为神经网络中“符号逻辑涌现”。我们试图在数学上证明符号逻辑涌现的根本原因——是神经网络的结构造成的,还是其他因素造成的?任何得到充分优化的黑盒模型是否都会出现符号化逻辑的涌现呢?当然,目前只是很初步的工作。

作者 | 唐灵 任启涵 张拳石

这个话题很大,严谨的研究需要我们把问题收回来,仅仅讨论一个小问题——我们发现绝大部分神经网络在测试样本上分类置信度可以解构成简单的符号化的交互逻辑,并且这样交互逻辑在不同样本和不同模型上还有一点的泛化性。我们将其视为神经网络中“符号逻辑涌现”,并探讨符号逻辑涌现的根本原因——是神经网络的结构造成的,还是其他因素造成的?任何得到充分优化的黑盒模型是否都会出现符号化逻辑的涌现呢?

不同于Intelligence Technology,Intelligence Science往往关注不一样的问题。如果不从工程技术的角度去关注具体任务中的问题和挑战,如果跳出目前工程化的体系,而把神经网络视为一个黑盒整体去分析智能系统中逻辑推理能力的涌现,我们的前期论文本质上关注着两个根本问题,虽然我们仅仅可以在某个层面上做出部分回答。

第一个问题是,人工智能模型中逻辑推理能力涌现的根本原因是什么?神经网络结构设计是逻辑推理涌现的根本原因,还仅仅是其表征载体之一呢?“逻辑推理”目前还是一个很模糊的词,并没有得到很好的定义。如果将模型视为一个拟合任务,那么有人将一个模型的“向外插值能力”视为推理和泛化,而将“向内插值能力”视为对训练样本的刻板记忆,但这个角度还是不完善的。这里的逻辑推理能力是指一定程度上“举一反三”的能力,在未知数据上实现一定程度上的推理预测的能力,而不仅仅是对训练样本的记忆。这里,推理能力涌现的基础,就是内在符号化概念的涌现,需要将具象的样本信息归纳总结为抽象的高层概念,而高层推理往往是在抽象的概念基础之上的。

第二个问题是,是否可以证明神经网络的决策逻辑可以相对严谨地解释为符号化的概念,实现对神经网络的可证明、可量化、可验证、可担责的解释呢?相比人工智能系统,人类拥有两套认知系统,一种是直觉的潜意识系统,而另一种是符号化的认知系统。如果没有第二套符号化系统,一般很难去实现深入的逻辑推理,人工智能仅仅会停留在对数据的记忆层面。我们需要探索第二套认知系统的来源,并且探索在什么情况下神经网络会自主学习到这种稀疏的符号化的认知系统。

针对上述两个问题,我们做了一些基本的理论探索。

1. 首先我们证明了在大部分情况下神经网络的决策逻辑可以相对严谨地解释为符号化的概念[1,2]。

交互概念的定义。我们考虑一个训练好的神经网络v, 以及一个包含n个输入单元的输入样本。每个交互对应于一个输入单元的集合𝑆,是这n个输入单元的子集。S中有m个输入单元(m<n),如果这S个单元间有交互,那么意味着神经网络建模了这m个输入单元之间的非线性关系,并会对神经网络的输出会产生一个额外的数值效用𝐼(𝑆)。在数学上,交互𝑆的数值效用𝐼(𝑆)定义如下:

其中xT是一个遮挡样本,表示样本x在集合T以外的输入单元被遮挡,而在集合T中的输入单元保持不变,v(xT)则表示神经网络在该遮挡样本xT上的输出。

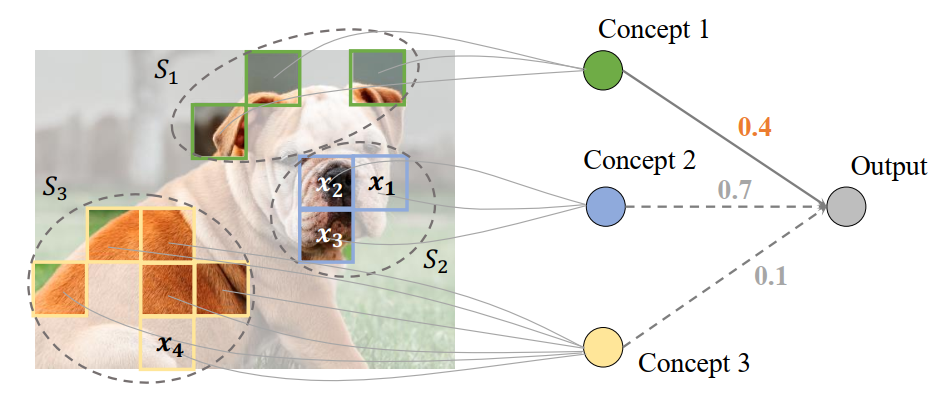

上述交互可以理解为一种“与关系”。当集合𝑆中每个输入单元都出现时,该交互被触发,同时对神经网络的输出产生一个额外的数值效用𝐼(𝑆)。相反,如果集合𝑆中任意一个输入单元被遮挡,则无法触发相应的交互,对网络输出的数值效用也随之消失。如下图所示,一个用于识别狗的图像的神经网络可能会建模“x1=狗脸颊”“x2=狗鼻子”和“x3=狗嘴”这三个图像区域之间形成的交互S2={x1,x2,x3}。只有当这三个图像区域全部出现时,该交互才被触发,并对神经网络输出产生一定的数值效用I(S2)=0.7。如果任意一个图像区域被遮挡,比如图中“狗脸颊”这一区域被遮挡,那么该交互就不被触发。

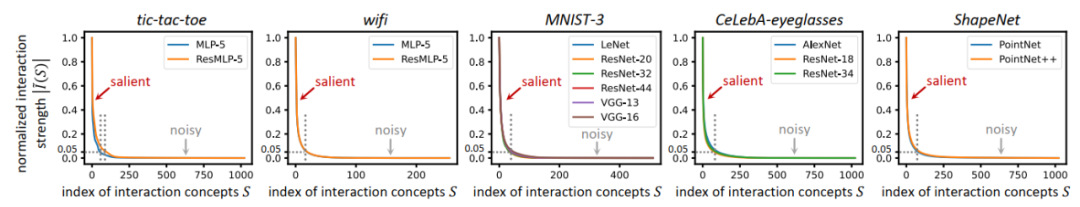

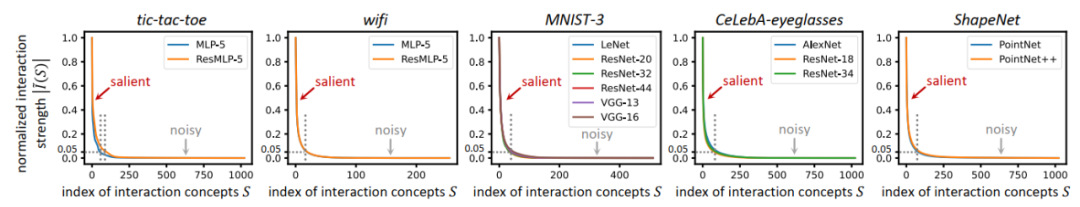

证明神经网络往往建模少量稀疏的交互概念。我们证明在一系列“一般性”条件下,一个充分训练的神经网络往往仅仅会建模极少量的交互作用,我们称之为交互概念。神经网络所建模的交互往往都是稀疏的,即神经网络所建模的大部分交互的数值效用都接近于0(对于大部分子集S,I(S)=0),只有极少量的交互对网络输出产生了显著的贡献(只有极少的集合S对于显著的I(S))。

特别地,我们把具有显著数值效用的交互叫做“交互概念”,而那些数值效用的绝对值接近于0交互则可视为“噪声”。也就是说,神经网络中自发涌现出了稀疏的符号化交互概念。

我们从理论上证明了当一个神经网络满足下列三个条件时,它仅会建模极少量的显著交互,而大多数交互都是效用接近于0的噪声。这三个条件具体如下:

条件一:我们假设模型不建模过于高阶的梯度信息,比如假设神经网络softmax 层之前的网络输出对输入的高阶梯度很小或为0。

条件二:不失一般性,在很多分类任务中,对输入样本的遮挡现象是普遍存在的。我们假设模型的输出随输入样本上遮挡程度的降低而大致单调增长,即输入样本的遮挡越少,模型分类的置信分数越高。

条件三:我们假设模型的输出对输入样本的遮挡程度具有鲁棒性,即当输入样本的遮挡程度逐渐降低时,模型输出的增长速度不快于多项式量级。这一假设保证了模型在遮挡的样本上的分类性能,其分类置信分数不会过低。

证明神经网络的决策逻辑可以归纳为不同交互概念的效用和。我们证明了在当满足上述三个条件时,神经网络的决策逻辑可以相对严谨地解释为符号化的概念。即,我们可以用少量交互概念的数值效用拟合出输入样本在任意遮挡状态下神经网络的输出值。我们证明了神经网络在任意遮挡的输入样本下的输出均可以精确地表示不同交互的数值效用的和的形式,即 forallTsubset N, v(x_T) = ∑_{T’subsetT} I(T’)。

进一步地,结合第一点中所证明的交互的稀疏性,我们将这些显著交互的集合记为Omega_{textit{salient}}。因此,我们可以得到下列关系:forallTsubset N, v(x_T)approxsum_{Omega_{textit{salient}}} I(T’),即,我们只需要用少量的显著交互概念的数值效用就可以拟合输入样本在任意遮挡状态下神经网络的输出值。

概念的迁移性、鲁棒性和分类性。此外我们还发现了[概念的模型间迁移性][3] 在同一数据集上训练的结构不同、参数不同的神经网络往往建模了相似的一组交互概念。[概念的样本间迁移性][3] 同一交互概念往往会出现在同一类别的不同样本上。[概念的分类性][3] 同一交互概念的数值效用往往对于分类起到一致的正向(或一致的负向)作用。[概念的鲁棒性][4] 交互概念的对抗敏感度与其交互的阶数(复杂度)相关。

2. 更重要的是,上述对神经网络所建模的交互的稀疏性的证明中,我们没有使用神经网络的结构信息和参数信息,其说明神经网络只是“符号化概念涌现或逻辑推理能力涌现的一种载体”,而不是逻辑推理能力涌现的根本原因。

根本上,上述证明可等同于,只要满足前文所提的三个条件时,任何人工智能模型都可以出现符号化概念的涌现现象。而人工智能模型是否潜在地将其决策逻辑表征为符号化的概念,是其实现进一步复杂推理的前提。

人工智能模型往往有三个方面:建模目标、表征手段、和优化问题。建模目标往往对应损失函数,即模型根本的优化目标。表征手段可以是神经网络、图模型、等等不同方式。优化问题往往包括优化算法是否能够有效的寻找到最优解,或者神经网络设计是否降低了优化难度(比如残差网络的skip connection)。我们证明的结论表明,模型中符号化概念的涌现与建模目标和优化问题更加相关——即模型是否可以在遮挡样本上有效地检测,而与表征手段似乎关系不大。它表明神经网络只是一种表征手段,不过因其参数量大、表达能力强,在大数据上得到充分优化问题,从而涌现了符号化概念。然而,神经网络并非智能涌现的根本,在充分优化的条件下,任何人工智能模型(比如图模型)都能够表现出符号化的特征。

参考文献

[1] Qihan Ren, Jiayang Gao, Wen Shen, Quanshi Zhang. “Where We Have Arrived in Proving the Emergence of Sparse Symbolic Concepts in AI Models” in arXiv:2305.01939

[2] Jie Ren, Mingjie Li, Qirui Chen, Huiqi Deng, Quanshi Zhang. “Defining and Quantifying the Emergence of Sparse Concepts in DNNs” in CVPR 2023

[3] Mingjie Li, Quanshi Zhang. “Does a Neural Network Really Encode Symbolic Concepts?” in ICML 2023

[4] Jie Ren, Die Zhang, Yisen Wang, Lu Chen, Zhanpeng Zhou, Yiting Chen, Xu Cheng, Xin Wang, Meng Zhou, Jie Shi, Quanshi Zhang. “A Unified Game-Theoretic Interpretation of Adversarial Robustness” in Neurips 2021

[5] Huiqi Deng, Qihan Ren, Hao Zhang, Quanshi Zhang. “Discovering and Explaining the Representation Bottleneck of DNNs” in ICLR (Oral) 2022

END