首个中英双语,开源语音对话大模型发布!

添加书签

专注AIGC领域的专业社区,关注OpenAI、百度文心一言等大语言模型(LLM)的发展和应用落地,关注LLM的基准评测和市场研究,欢迎关注!

萧箫 发自 凹非寺

量子位 | 公众号 QbitAI

首个中英双语的语音对话开源大模型来了!

这几天,一篇关于语音-文本多模态大模型的论文出现在arXiv上,署名公司中出现了李开复旗下大模型公司01.ai——零一万物的名字。

这篇论文提出了一个中英双语可商用对话模型LLaSM,同时支持录音和文本输入,“混合双打”也没有问题:

论文认为,“语音聊天”才是AI与人之间更方便自然的交互方式,而不仅仅是通过文本输入。

用上大模型,有网友已经在想象“躺着说话就能写代码”的场景了。

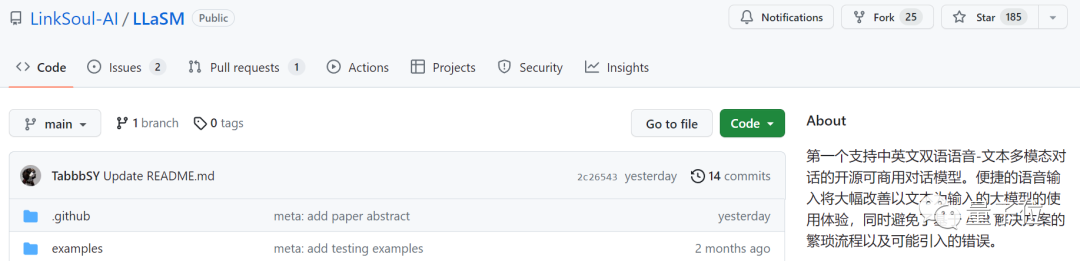

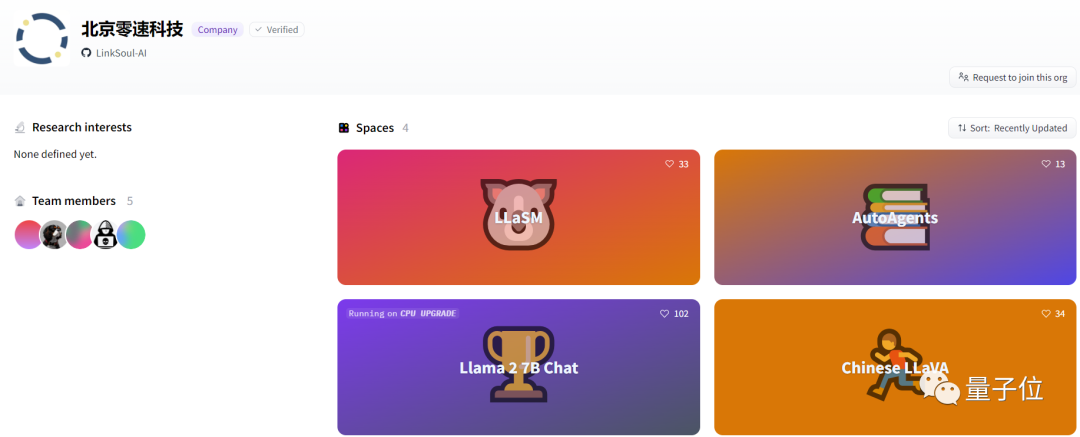

这项研究来自LinkSoul.AI、北大和零一万物,目前已经开源,也可以在抱抱脸中直接试玩。

一起来看看它的效果如何。

支持文本语音输入,手机也可玩

据研究人员表示,LLaSM是第一个支持中英文双语语音-文本多模态对话的开源可商用对话模型。

那么,就来看看它的语音文本输入和中英双语能力如何。

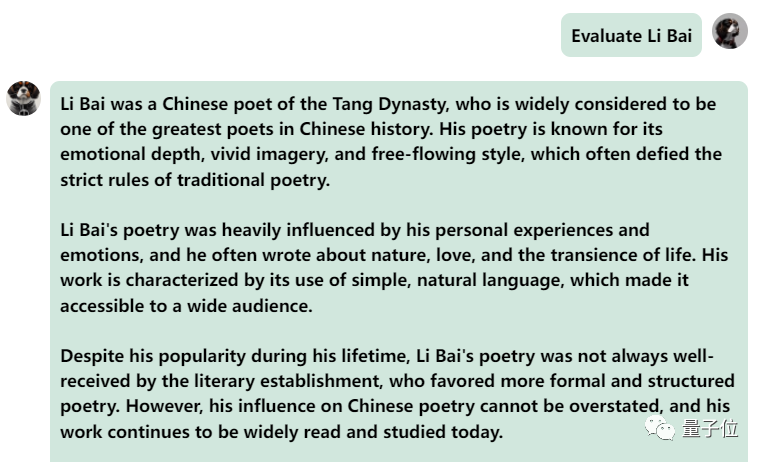

首先来个中英文化碰撞,让它用英文评价一下李白:

还可以,正确地说出了李白的朝代。如果看不懂英文,让它直接翻译成中文也没问题:

接下来再试试中英混合提问,在中文里面掺杂一个“fried food”,模型输出也不错:

再试探一下模型,让它进行一些评价,看看李白和杜甫哪个更厉害。

可以看出,模型思考一会后给出了非常中立的评价,也具备大模型的基本“端水常识”(手动狗头)

当然,不止是电脑,手机也能玩。

我们试着用语音输入“给我推荐一个菜谱吧”:

可以看到模型准确地输出了一个“茄子芝士”的菜谱,就是不知道好不好吃。

不过,我们在尝试的时候也发现,这个模型有时候会出bug。

例如有时候它并不能很好地“听懂人话”。

要求输出中英混合的内容,它会假装看不懂并输出英文:

而当中英混合询问想听“Taylor Swift的Red”时,模型更是直接出大bug,反反复复输出一句话,甚至停不下来……

总体来看,当遇到中英混合的提问或要求时,模型输出能力还是不太行。

不过分开的话,它的中英文表述能力还是不错的。

那么,这样的模型究竟是怎么实现的呢?

做了个什么新模型?

从试玩来看,LLaSM主要有两个特点:一个是支持中英输入,另一个是语音文本双输入。

要做到这两点,分别需要在架构和训练数据上做一些调整。

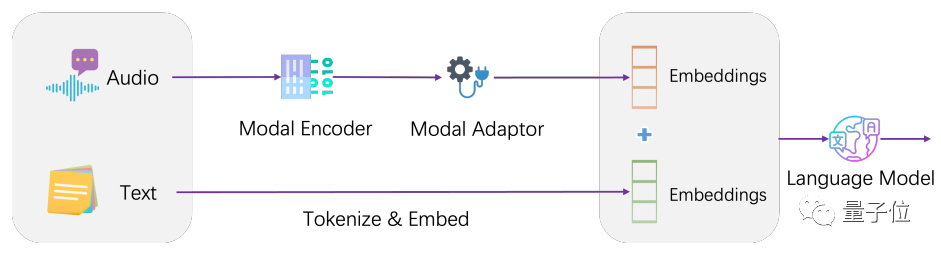

架构上,LLaSM将当前的语音识别模型和大语言模型做了个整合。

LLaSM由三个部分构成,分别包括自动语音识别模型Whisper、模态适配器和大模型LLaMA。

其中,Whisper负责接收原始语音输入,并输出语音特征的向量表示;模态适配器负责对齐语音和文本嵌入;LLaMA则负责理解语音和文本输入的指令,并生成回复。

模型的训练一共分为两个阶段,第一阶段训练模态适配器,冻结编码器和大模型,也就是让它来学习语音和文本对齐;第二阶段冻结编码器,训练模态适配器和大模型,来学习多模态对话能力。

训练数据上,研究人员整理出了一个包含19.9万个对话和50.8万个语音-文本样本的数据集LLaSM-Audio-Instructions。

而在50.8万个语音-文本样本中,有8万个中文语音样本,42.8万个英文语音样本。

研究人员主要基于WizardLM、ShareGPT和GPT-4-LLM等数据集,通过文本转语音技术,给这些数据集生成语音包,同时过滤掉无效对话。

这也是目前最大的中英文语音文本指令遵循数据集,不过目前还在整理中,据研究人员表示,整理完后会进行开源。

不过,论文暂时没有对比它和其他语音模型或文本模型的输出效果。

作者介绍

这篇论文来自LinkSoul.AI、北京大学和零一万物。

共同一作Yu Shu和Siwei Dong均来自LinkSoul.AI,此前曾经在北京智源人工智能研究院工作。

LinkSoul.AI是一家AI初创公司,之前推出过首个开源Llama 2的中文语言大模型。

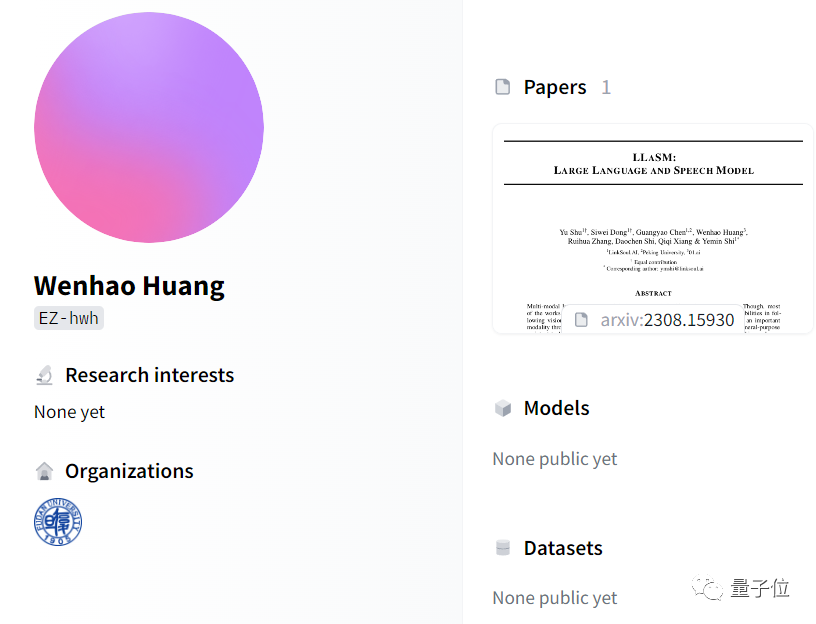

作为李开复旗下的大模型公司,零一万物也在这次研究中有所贡献。作者Wenhao Huang的Hugging Face主页显示,他毕业于复旦大学。

论文地址:

https://arxiv.org/abs/2308.15930

Demo地址:

https://huggingface.co/LinkSoul/LLaSM-Cllama2

本文素材来源量子位,如有侵权请联系删除

END