将大语言模型推理能力提升数倍,英伟达推出NVIDIA TensorRT-LLM

添加书签

专注AIGC领域的专业社区,关注OpenAI、百度文心一言等大语言模型(LLM)的发展和应用落地,关注LLM的基准评测和市场研究,欢迎关注!

9月9日,全球人工智能领导者英伟达(NVIDIA)在官网宣布,推出NVIDIA TensorRT-LLM用于提升大语言模型的推理能力。

据悉,TensorRT-LLM由TensorRT深度学习编译器组成,包括优化的内核、预处理和后处理,以及用于在NVIDIA GPU上实现突破性的多GPU/多节点通信。

这使开发人员能以最高性能和快速自定义功能,而无需深入了解C++或NVIDIA CUDA快速尝试不同的大语言模型。

目前,TensorRT-LLM处于测试阶段,未来几周内会正式发布并开源。(申请地址:https://developer.nvidia.com/tensorrt-llm-early-access)

ChatGPT等大语言模型展示出了前所未有的强大功能,能生成各种文本、提取摘要、分析数据等。但功能越强大参数就越高,例如,GPT-3.5达到1750亿参数,开发者需要耗费大量算力才能投入使用。

因此,英伟达推出TensorRT-LLM,帮助开发者加速和优化大语言模型的推理能力,以最少的算力资源开发更强大的生成式AI产品。

TensorRT-LLM性能评测

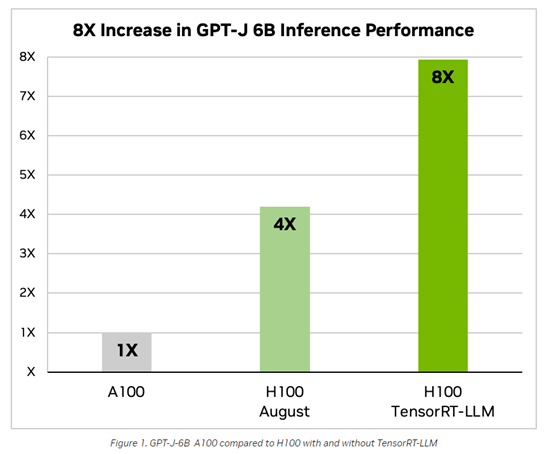

自动生成摘是大语言模型常用功能之一,在此测试中,TensorRT-LLM 在最新 NVIDIA Hopper 架构上实现了性能突破。

例如,H100在TensorRT-LLM的加持下,将GPT-J 6B大模型的推理能力提升了8倍。

在Meta发布的Llama 2 700亿参数大预言模型上,TensorRT-LLM可以将推理性能比 A100 GPU提高 4.6倍。

运行方法和适配模型

目前,大语言模型正处于高速发展阶段,一些最大、最先进的语言模型,比如Meta的700亿参数的Llama 2,需要多个GPU配合工作才能达到最佳效果。因此,开发者必须重写并手动将AI模型分割成片段,并在GPU之间协调工作。

TensorRT-LLM采用了张量并行性的方法,其中单个权重矩阵在设备之间分割。这使得可以在大规模上实现高效推理,模型可在通过NVLink连接的多个GPU以及多个服务器之间并行运行,而无需开发者干预或更改模型。

目前,TensorRT-LLM已完全优化好,无需任何修改即可投入使用的模型包括:Meta的 Llama 2,OpenAI 的GPT-2和GPT-3,Falcon,Mosaic MPT,BLOOM等十多种主流大语言模型。

未来,TensorRT-LLM还会持续扩大对大语言模型的支持范围,使得开发人员能以低能效、高效率快速开发属于自己的产品以满足业务需求。

本文素材来源英伟达官网,如有侵权请联系删除

END