中国等28个国家发布《布莱切利宣言》,鼓励AI以安全方式发展

添加书签

专注AIGC领域的专业社区,关注微软OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

英国时间11月1日,中国、美国、英国、法国、德国等28个国家和欧盟,在英国的布莱切利庄园签署了,首个全球性人工智能(AI)声明——《布莱切利宣言》。

该宣言明确指出了AI对人类社会的巨大机遇,但AI需要以人为本、可信赖、负责任的方式设计和使用造福全人类。

特别指出了“前沿”AI可能带来的风险,例如,ChatGPT、Bard、Midjourney等大语言模型以及其他“超”能力的狭义AI。这类系统的能力难以预测,可能被误用或失控。

所以,呼吁国际社会通力合作,在现有的国际论坛下制定政策和法规来提升透明度、问责制,并加强对这类前沿AI的科学研究与风险评估,以安全、健康、可靠的方式发展和应用AI。

宣言地址:https://www.gov.uk/government/publications/ai-safety-summit-2023-the-bletchley-declaration/the-bletchley-declaration-by-countries-attending-the-ai-safety-summit-1-2-november-2023

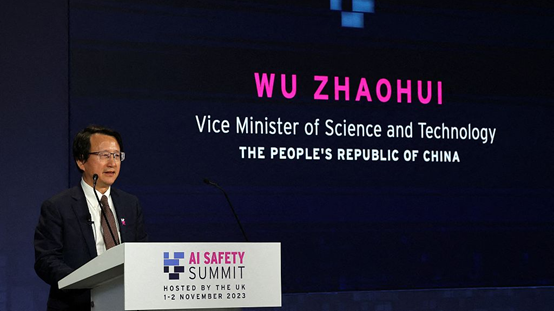

中国科技部副部长-吴朝晖率团出席此次峰会,参与AI安全等问题讨论,积极宣介中方提出的《全球AI治理倡议》,并将与相关国家开展双边会谈。

中国科技部副部长吴朝晖

中国科技部副部长吴朝晖

此外,中国科学院、微软、腾讯、阿里巴巴、马斯克、OpenAI首席执行官Sam Altman、谷歌DeepMind首席执行官Demis Hassabis等科技界知名人士出席了会议。

以下是《布莱切利宣言》内容

AI为全球带来巨大机遇:能改造和提升人类福祉、和平与繁荣。为了实现这一目标,我们坚定认为,为了全人类福祉,AI的设计、开发、部署和使用都应该以安全、以人为本、可信赖和负责任的方式进行。

欢迎国际社会迄今为止在AI领域的合作努力,以促进包容性经济增长、可持续发展和创新,保护人权和基本自由,并增强公众对AI系统的信任和信心,以充分发挥其潜力。

AI系统已经被部署到日常生活的许多领域,包括住房、就业、交通、教育、健康、无障碍环境和司法等,且其使用还在不断增加。我们认识到,这是一个采取行动的关键时刻,需要确保AI的安全发展,以及AI的转型性机遇惠及所有人,包容地应用于我们各国以及全球。

这包括公共服务领域如健康和教育,粮食安全,科学,清洁能源,生物多样性和气候等,以实现人权保障,并加强实现联合国可持续发展目标的努力。与这些机遇同时,AI也带来重大风险,包括日常生活领域的风险。

为此,我们欢迎相关国际力量通过现有论坛和其他相关倡议,审视和应对AI系统潜在影响的努力,以及对保护人权、透明度和解释性、公平性、问责制、监管、安全性、适当的人类监督、伦理、偏见缓解、隐私和数据保护等问题的重视。我们还注意到操纵内容或生成误导内容的能力可能带来难以预见的风险。所有这些问题都至关重要,我们坚定需要并迫切地解决这些问题。

在AI的“前沿”领域存在特定的安全风险,这些前沿领域是指那些高度能力的通用AI模型,包括基础模型,可以执行各种各样的任务,以及可能展示出可能造成伤害的能力的相关特定狭义AI,其能力匹配或超过了当今最先进模型所具有的能力。

这些AI模型的重大能力可能会由于潜在的故意滥用或与人类意图不一致所导致的无意中的控制问题而产生实质性风险。

由于这些能力并不为人完全理解,因此很难预测,这也是导致上述问题的部分原因。我们特别关注此类风险可能出现在网络安全、生物技术等领域,以及前沿AI系统可能会放大错误信息等其他风险。

马斯克谈AI影响

这些AI模型最强大的能力,无论是故意还是无意,都存在造成严重甚至灾难性伤害的可能。鉴于AI变化迅速且难以预测,以及技术投资正在加速,我们坚信,深入理解这些潜在风险以及解决这些风险的行动尤为紧迫。

许多AI风险本质上具有国际性,因此最好通过国际合作来解决。我们决心以包容的方式共同努力,通过现有的国际论坛和其他相关倡议,确保以人为本、可信赖和负责任的安全AI,造福所有人。我们将促进合作,以应对AI带来的广泛风险。

在此过程中,我们认识到,各国应考虑采取有利于创新和适度治理与监管的方法,以最大限度发挥AI的效益,并考虑其相关风险。这可能包括在适当情况下,根据国情和适用的法律框架,对风险进行分类和归类。

我们还注意到,在适当情况下,合作开发共同原则和行为守则等方法的相关性。关于前沿AI相关的具体风险,我们决心加强和持续我们的合作,并与更多国家 扩大合作,通过现有的国际论坛和其他相关倡议,识别、理解这些风险,并在适当情况下采取行动,包括未来的国际AI安全峰会。

所有行为体在确保AI安全方面都有角色发挥:各国、国际论坛和其他倡议、企业、公民社会和学术界需要共同努力。我们注意到包容性AI和弥合数字鸿沟的重要性,重申国际合作应努力吸引和邀请广泛的合作伙伴参与,我们欢迎那些有助于发展中国家加强AI能力建设、发挥AI的支持作用以促进可持续增长和弥合发展差距的面向发展的方法和政策。

我们坚信,尽管必须全生命周期考虑安全性,但开发前沿AI能力的行为体,特别是开发异常强大、潜在有害的AI系统的行为体,有非常重要的责任来确保这些系统的安全,包括通过安全测试系统、评估等适当措施。

鼓励所有相关行为体根据上下文提供透明度和问责制,对其计划测量、监控和缓解可能的有害能力及相关后果的计划提供透明度和问责制,特别是为了防止误用和控制问题以及放大其他风险。

在我们合作的背景下,为了指导国家和国际层面的行动,我们关于应对前沿AI风险的议程将聚焦于:

识别共同关注的AI安全风险,建立共享的科学和基于证据的这些风险理解,并随着能力的不断提高而持续这种理解,在更广泛的全球方法来理解AI对我们社会的影响的背景下。

在各国构建基于风险的政策,根据这些风险确保安全,在适当情况下开展协作,同时认识到我们的方法可能基于国情和适用的法律框架而有所不同。

这包括私营部门开发前沿AI能力的行为体提高透明度以外,还包括适当的评估指标、安全测试工具,以及开发相关的公共部门能力建设和科学研究。

为推进这一议程,我们决心支持一个国际包容的前沿AI安全科学研究网络,其涵盖并补充现有和新的多边、小集团和双边合作,包括通过现有的国际论坛和其他相关倡议,以便为政策制定和公共利益提供最佳的科学依据。

鉴于AI巨大的正面转型潜力,并作为确保AI更广泛国际合作的一部分,我们决心维持一个包容的全球对话,吸引现有国际论坛和其他相关倡议,并以开放的方式对更广泛的国际讨论做出贡献;我们将继续开展前沿AI安全研究,以确保这项技术的利益可以被负责任地造福全人类。

出席的国家:

-

中国 -

澳大利亚 -

巴西 -

加拿大 -

智利 -

欧洲联盟 -

法国 -

德国 -

印度 -

印度尼西亚 -

爱尔兰 -

以色列 -

意大利 -

日本 -

肯尼亚 -

沙特阿拉伯王国 -

荷兰 -

尼日利亚 -

菲律宾人 -

大韩民国 -

卢旺达 -

新加坡 -

西班牙 -

瑞士 -

土耳其 -

乌克兰 -

阿拉伯联合酋长国 -

大不列颠及北爱尔兰联合王国 -

美国

本文素材来源英国国家官网,如有侵权请联系删除

END