文本直接生成多视角3D图像,Meta推出创新模型

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

随着扩散模型的不断创新,文生图领域出现了Midjourney、Stable Diffusion、DALL-E 3等一系列知名产品。

但在文本生成多视角3D图像方面一直存在诸多技术难点,Meta和德国慕尼黑工业大学的研究人员联合开发了创新模型——ViewDiff。

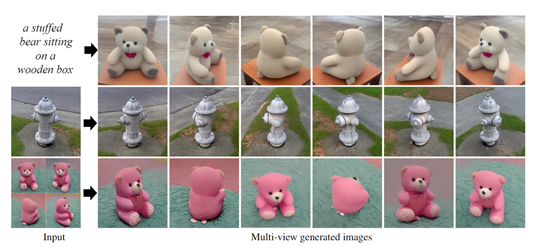

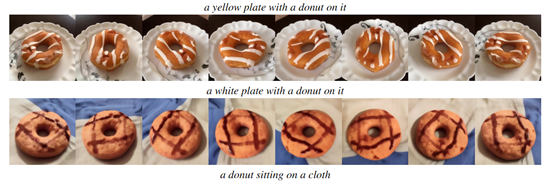

用户通过文本、图像或二者结合使用,就能生成高质量多视角3D图像,可帮助游戏开发、元宇宙等行业快速构建模型。

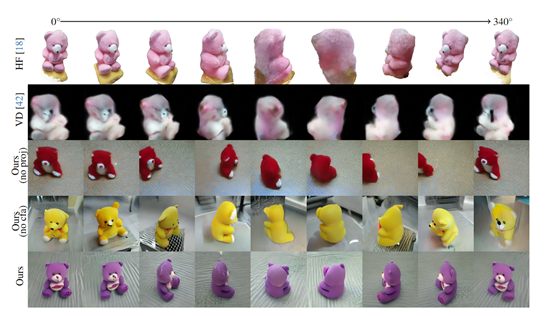

根据测试数据显示,ViewDiff生成的图像在一致性和视觉质量方面非常出色,并将FID、KID的数据,分别提升了30%和37%。

论文地址:https://arxiv.org/abs/2403.01807

项目地址:https://lukashoel.github.io/ViewDiff/

目前,文本生成一致性、多视角3D图像主要有三大难点:通常无法生成真实的背景环境,大多数只能在简单或纯色背景上渲染3D物体模型,缺乏与自然环境的融合;

生成图像的质量和多样性不理想,由于受限于训练数据的规模,一些方法只能产生质量有限、风格单一的输出;

缺乏多视角和一致性,大多数方法都是独立生成单一视角,无法确保同一物体在不同视角下的几何和外观的一致性,这极大限制了3D图像的实用性。

而ViewDiff使用了一种创新架构,先使用文生图模型作为先验知识和图像流生成器,然后通过显式的3D建模为图像赋予生成一致性、多视角3D图像的能力。

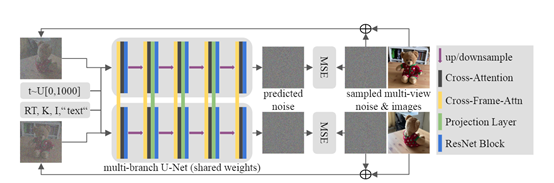

增强U-Net架构

为了使文生图模型能够有效捕获3D几何和全局风格,研究人员对原有U-Net架构进行了创新,添加了两种新的层:跨帧注意力层和投影层。

1)跨帧注意力层:主要替换了U-Net中的标准自注意力层。不同于只关注单个图像内部的特征,跨帧注意力层将每个图像的特征与其他所有图像的特征进行交互,实现了跨图像的风格匹配。

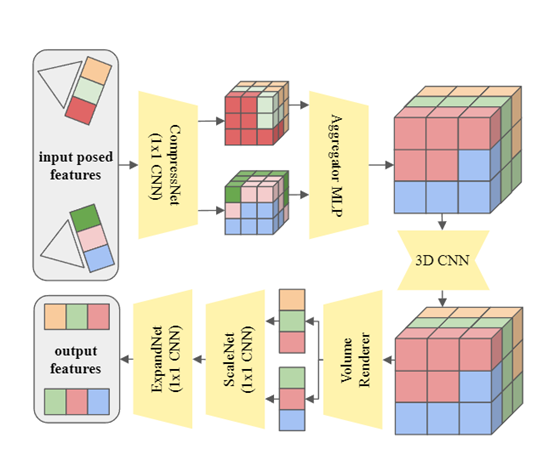

2)投影层:虽然跨帧注意力层能协调全局风格,但它无法显式地对3D几何知识进行建模。

因此,研究人员又开发了投影层,将多视图2D特征集成为一个显式的3D体素特征,再将其渲染回2D特征,保证了输出图像的3D几何一致性。

原U-Net架构在跨帧注意力层和投影层的增强下,使得ViewDiff能够在各个尺度上对2D特征进行3D感知建模,并实现多视图图像的风格协调,最终生成一致性、高质量的3D图像。

自回归生成

为了在任意视角上生成更多的3D一致性图像,ViewDiff开发了自回归生成模块,将允许从已生成的图像继续生成更多的图像,以呈现不同的视角。

首先,给定一个初始图像,可以是输入的多视角生成的图像中的任意一个。这个初始图像将作为生成过程的起点。

然后初始图像通过编码器网络,提取出特征表示。编码器网络通常由卷积层和池化层组成,用于逐渐减小特征图的尺寸和提取高级语义特征。

接着编码器的特征表示被送入解码器网络,解码器网络的结构与编码器相反。解码器逐渐增加特征图的尺寸,并通过反卷积等操作生成更高分辨率的图像。

解码器的每个步骤都会生成一个新的图像,并将其与之前生成的图像进行叠加,形成一个新的输入。

这个新的输入将作为下一个步骤的输入,以生成下一个新的图像。通过不断迭代生成新的图像,使得ViewDiff能够在任意视角上生成更多的3D一致性图像。

本文素材来源ViewDiff论文,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区