太逼真了!Gen-3 Alpha重磅发布,Sora最强竞争对手!

添加书签

专注AIGC领域的专业社区,关注微软&OpenAI、百度文心一言、讯飞星火等大语言模型(LLM)的发展和应用落地,聚焦LLM的市场研究和AIGC开发者生态,欢迎关注!

6月17日晚,著名生成式AI平台Runway在官网发布了,全新文生视频模型——Gen-3 Alpha。

与Gen-2相比,Gen-3在生成视频的质量、色彩、饱和度、光影、文本语义还原、运镜、动作一致性、场景切换等实现大幅度提升。

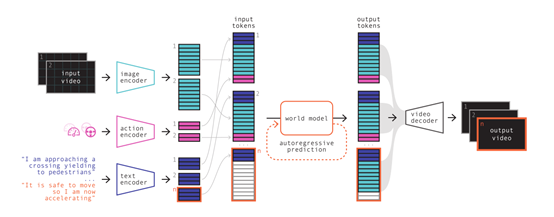

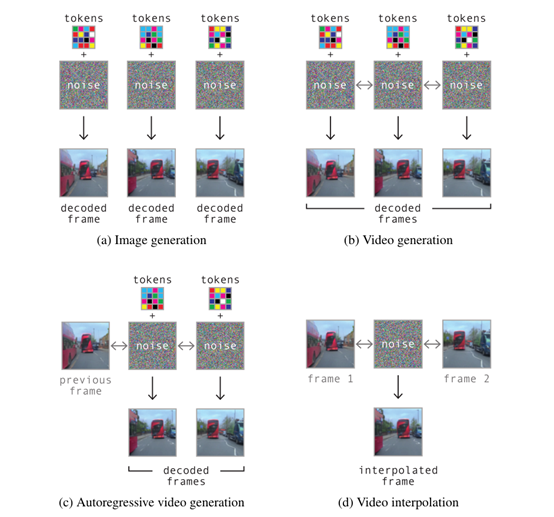

此外,Gen-3和Sora、可灵、Dream Machine一样是个世界模型,具备模拟物理世界的能力。也就是说,其生成视频的物理效果,例如,下落、碰撞、触摸、风吹、生长、雨水等都非常逼真。

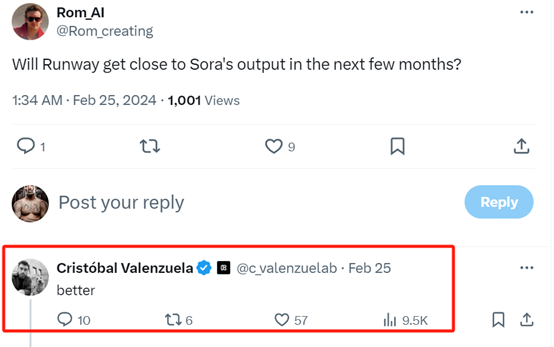

值得一提的是,Runway的联合创始人曾在今年2月25日说过,要做出比Sora更好的文生视频,果然兑现了诺言。

Gen-3案例展示与解读

虽然Gen-3还没有正式全面公测,但已经邀请了影视、开发等人员进行了内测,流出来的视频效果非常棒, 一次可以生成11秒的视频。

下面「AIGC开放社区」选了一些非常有特色的Gen-3视频,并为大家解读它们到底好在哪里。

例如,一顶卷发假发和墨镜突然落在他的头上,一位悲伤的秃头中年男人变得高兴起来。

在这个案例中,我们可以仔细观察他的眼睛睁开速度和嘴巴逐渐微笑的走势,以及戴上假发、墨镜之后,笑容发生的微妙变化,是不是看起来非常逼真。

在高速行驶的火车车窗旁,一名女子的微妙倒影,这个主要体现了Gen-3强大的光影能力。

火车在飞速行驶中,车窗外的霓虹灯照在女人的脸上,在她的脸颊、鼻子上都有不同层次的效果,同时她受到光的刺激后,还会自然地眨眼,这一点很人性化、很了不起。

这个在闹市的火焰圈,也展示出了同样的光影渐变效果。

一位年轻女子驾驶汽车的特写镜头,看上去若有所思,透过雨天的车窗可以看到模糊的绿色森林。这个和上一个火车女的案例差不多,但生成的难度要大很多。

首先,要体现女子的表情,文本要求的是“若有所思”,Gen-3选择使用紧闭嘴巴和不眨眼来表现;

其次就是透过雨天的车窗,这就需要雨点在汽车高速行驶之下表现出不同的雨水拍打效果。整体来看,完成的非常棒!

一个晶莹剔透的水晶盒,有一些彩色的球掉落下来。我们观察到,第一批掉落下来的篮球、绿球、黄球的回弹性非常好,随着掉落的球越来越多,弹性也变得缓慢起来,这个展示的就是物理下落和碰撞等效果。

一个蚂蚁从巢穴中出来的,很近的特写镜头。镜头拉回来,露出山那边的一个街区。这个主要体现了Gen-3的运镜、场景切换的能力。

给完蚂蚁特写之后,就是一个非常大的远景运镜,接着就要缓慢生成远处的街景,这对场景的连贯、一致性要求非常高。

空中拍摄的海洋,水中形成漩涡、不断旋转,直到露出下面炽热的深处。这个也是运镜和场景切换能力。

手持跟踪拍摄,跟踪废弃街道上漂浮的红色气球。这个展示了近大远小的物理效果,我们看到随着气球逐渐飘向远方,气球正在缓慢变小但是毫无违和感;再就是光影效果,仅在10秒钟镜头的光影却发生了两次变化,一次是短、一次是长。

一个废旧的空仓库,从地下冒出来一大片奇妙的绿色丛林。注意深林在出现的过程中发生了两次生成变化。

第一次,草坪是平的,在马上要见到阳光后,平的草坪立马变成了绿色的植被,同时遮盖住透进来的阳光。整个生长过程,基本是符合现实世界的规律。

世界模型的重要性

从上面这些案例,能体会到模拟物理世界的重要性了吧。其实,世界模型应用最广泛的是在汽车自动驾驶,可以帮助汽车在变化多端的环境中做出明智的决策、规划行动。

所以,OpenAI、Runway等也希望把该技术引入到文生视频领域,来增强生成视频的质量。

但开发特定的世界模型并不容易,首先需要对现实世界的动态和结构进行精确捕捉和模拟。这涉及到物体的物理属性,比如它们的大小、形状和质地,还有它们如何随时间在环境中移动和变化。

例如,在自动驾驶汽车领域,它需要一个能够准确预测其他车辆、行人、交通信号和道路条件变化的世界模型。

物理模拟是世界模型中核心模块之一,它允许AI模拟现实世界的物理定律,这对于预测物体如何运动和相互作用至关重要。例如,机器人在抓取物体时,它需要模拟物体的重量和可能的移动轨迹,以确保动作的精确和稳定。

此外,需要大量多类型数据,包括视频、图片、传感器等提供了源源不断的环境信息。然后通过深度学习、极佳的算法从这些数据中提取特征,学习规律,模拟出能够反映现实世界的模型。

世界模型不仅能体现当前的状态,其预测能力也是非常强。通过学习历史数据和模式,模型能够预测未来可能发生的情况,我们从视频生成的效果就能看出这一点,例如,那个在仓库中生长出绿色强的案例。

此外,世界模型使机器能够与环境进行交互,实时根据环境反馈调整行为。例如,自动驾驶汽车在行驶中会不断更新其世界模型,以反映周围环境的最新变化,并据此做出快速而准确的驾驶决策;

而文生视频模型,可以根据文本语义提示,在生成过程中实时调整生成的内容更好地还原文本提示。

2024——文生视频元年

在今年2月,Sora席卷全球成为现象级产品时,就有网友问过Runway的联合创始人Cristóbal Valenzuela:“几个月后,Runway能做出与Sora类似的产品吗?”

Cristóbal回答的也比较简单直接,会比Sora更好。从Gen-3生成的效果来看,他确实没吹牛做到了。

不少网友表示,Gen-3出现后,Sora迎来了最强竞争对手,整个文生视频赛道的竞争也变得更加残酷。

对Gen-3生成的视频质量也非常认可,并且认可这是文生视频领域最大竞争对手之一。

仅在6月,就有三款非常强的文生视频模型出现,2024简直就是“视频元年”。

在多个超强文生视频模型的围剿下,OpenAI快要失去护城河了,是时候赶紧公测Sora了。

也有人认为,Gen-3生成的效果已经超过了Sora,离制作电影级视频非常近了。

今年2月16日,OpenAI发布Sora后全球科技领域为之震惊,极大提升了文生视频赛道的热度,受到了影视行业、资本市场的青睐。

仅仅4个月后,国内快手发布的“可灵”, Luma AI发布的Dream Machine,加上今天的Gen-3 Alpha,在生成视频的质量、动作一致性等完全不输Sora,将模拟世界大模型拉升到一个全新高度。

如果2023年是ChatGPT文本元年,那么2024将是文生视频疯狂内卷的一年,我们期待下半年更多炸裂产品的出现。

本文素材来源Runway官网,如有侵权请联系删除

END

本篇文章来源于微信公众号: AIGC开放社区