专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

4月19日,Stability AI在官方博客宣布推出全新大语言模型StableLM。这是一个类ChatGPT模型,支持文本问答、创意写作、代码生成等功能。

据悉,StableLM推出了30亿、70亿参数两种版本,后续还将推出150亿和650亿,1750亿的大参数也在计划中。该模型允许商业化但必须遵守CCBY-SA-4.0许可的条款。

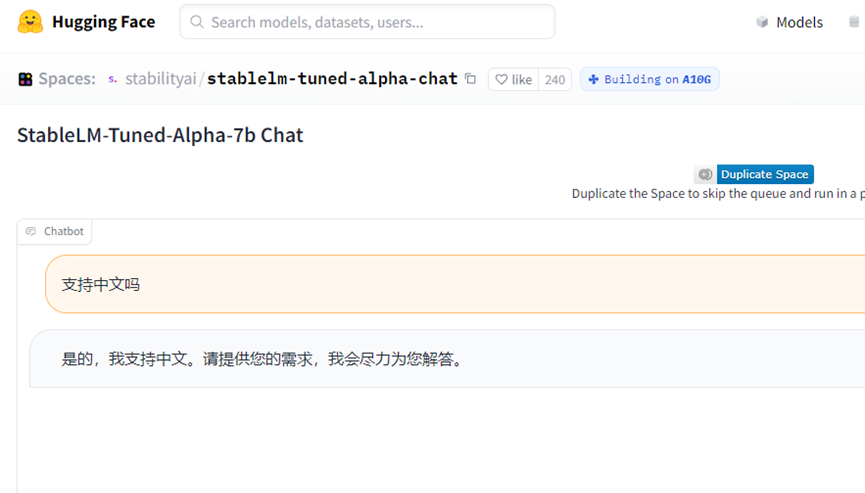

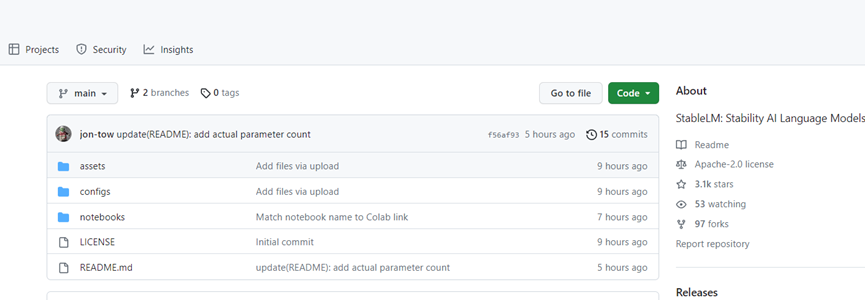

支持中文,但可能会出现偏差,StableLM也在持续优化中。StableLM仅用10个小时github已突破3000颗星,其高性能低资源消耗非常适用于中小型企业和个人开发者,普通笔记本也能运行。

开源地址:https://github.com/stability-AI/stableLM/

测试地址:https://huggingface.co/spaces/stabilityai/stablelm-tuned-alpha-chat

Stability AI是全球知名文本生成图片平台Stable Diffusion的开发商,其主要竞争对手是Midjourney。同时Stability AI也是最早开源扩散模型平台之一,现在通过发布StableLM切入大语言模型领域,这为Stability AI以后推出多模态类似GPT-4模型奠定了基础。

支持中文:「AIGC开放社区」通过在线demo试用了StableLM,可以通过中文进行问答、文本创作和故事编写。但有时候会出现偏差,理解能力低的情况。

支持商业化:StableLM是基于Eleuther AI模型开发而成,包括 GPT-J、GPT-NeoX 和Pythia套件。

其中,Eleuther AI的模型可以用于商业化,例如,同样支持商业化的Dolly 2.0便是基于该模型开发而成。目前,市面上基于LLaMA开源的模型都有一个明显致命缺点,无法实现商业化。

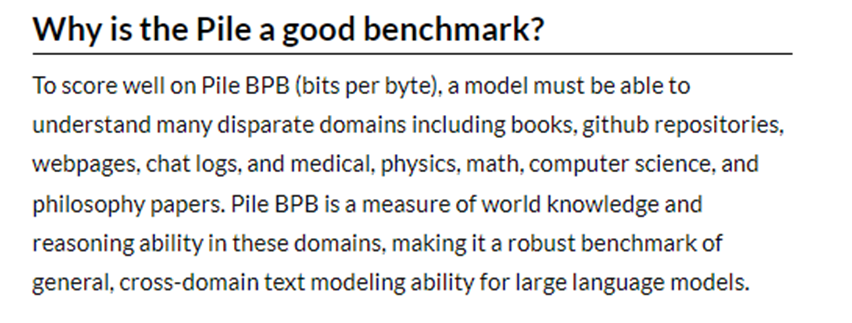

小参数,大训练:StableLM的参数只有30亿和70亿,但是训练数据达到了1.5万亿tokens,机器人的回答内容范围非常广。StableLM-Alpha模型在基于The Pile构建的新数据集上进行训练,内容包括,维基百科、github、网页抓取、物理、数学、医学、聊天记录等。

微调:为了提升StableLM模型的准确性,使用了Alpaca、gpt4all、RyokoAI、Dolly核心训练数据,以减少理解能力差、胡说八道、歧视、道德等问题。

低资源消耗:大语言模型的资源消耗与参数成正比,例如,GPT-3.5的1750亿参数需要庞大的算力集群才能使用。StableLM在小参数的基础上又进行了大量优化,这使得日常使用的笔记本电脑就能使用。如果使用算力更强的云服务体验效果更佳。

稳定迭代:Stability AI是Eleuther AI的懂事和主要赞助商之一,具备强大的技术研发和功能迭代能力,这为产品创新提供了保障。

兼容性强:StableLM模型兼容性超强,无需在特定的设备、芯片上运行,无论日常笔记本还是私人云服务器都能使用。

Stability AI表示,大语言模型作为全新的智能生产能力工具使用范围将非常广泛,所以,StableLM将数据安全、用户隐私和道德等列为技术研发的重中之重。

Stability AI希望通过开源StableLM让更多的学者、企业和个人开发者参与到大语言模型研究中,共同消除潜在的风险,使其成为大语言模型开源领域最易用产品之一。

Stability AI在2022年8月开源了Stable Diffusion,同年11月发布了2.0版本。苹果应用商店中排名前10的图片类应用程序中,有4个由Stable Diffusion 提供技术支持。

目前,Stability AI拥有一个超过14万名开发人员和7个研究中心组成的庞大人工智能生成内容社区,因此,在功能创新、预训练、算法优化和数据微调方面处于领先地位。

本文素材来源Stability AI,如有侵权请联系删除

END

加入AIGC开放社区交流群

添加微信:13331022201 ,备注“职位信息&名字”

管理员审核后加入讨论群