100万美元!OpenAI寻求ChatGPT等AI,安全规则建议

添加书签

专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

太平洋时间5月25日,OpenAI宣布旗下的非营利组织 OpenAI, Inc.启动一项“AI民主”计划。投资10笔10万美元共计100万美元资金,以资助实验建立一个民主程序,来决定AI系统在法律规定的范围内应遵循哪些规则。

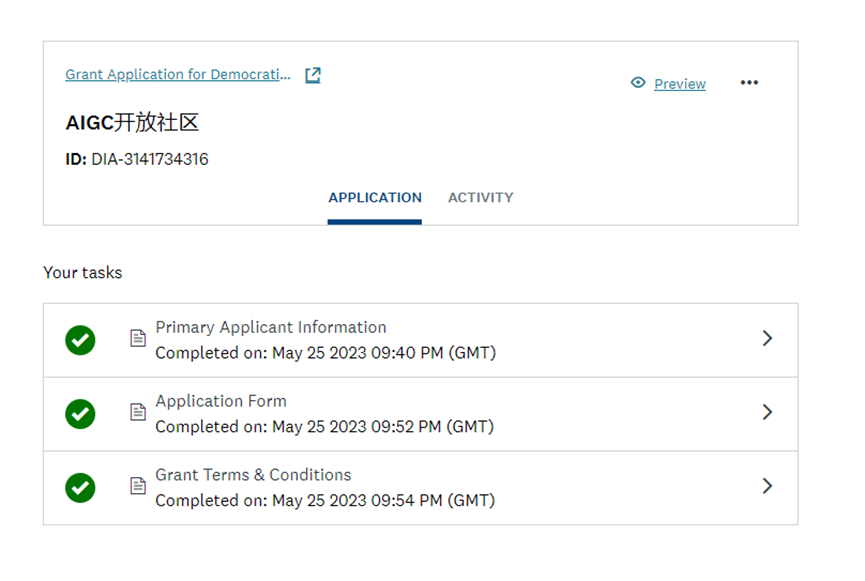

想获得这笔资金的用户,可在2023年6月24 日晚上9点之前,在https://openai.smapply.org/ 上进行申请。7月14日公布筛选结果并通知成功申请者。

AIGC开放社区已提交申请,正等待审核结果

OpenAI表示,ChatGPT等AI将对社会产生巨大影响和经济效益。但AI在提供商业价值的同时应该遵守法律框架、尊重个人数据隐私等,需要更复杂和适应性更强的行为准则。希望通过本次计划邀请世界各地的团队来开发民主过程的概念验证。

该过程可以回答有关人工智能系统应遵循哪些规则的问题。我们希望从这些实验中吸取教训,并将它们作为未来全球化技术推广的安全规则基础。

政策建议展示

范围涉及与模型行为有关的政策问题,因为它可以根据政策建议对修改后的模型行为进行 A/B 测试。

OpenAI认识到许多AI问题可以通过民主程序解决并控制模型行为,包括在各种情况下使用人工智能的指南、经济影响、利益分配等领域。以下是问题展示:

-

您认为ChatGPT等 AI助手的个性化应该走多远,才能符合用户的品味和偏好?在此过程中应该存在哪些界限? -

AI助手应该如何回答有关公众人物观点的问题?例如,他们应该保持中立吗?他们应该拒绝回答吗?他们应该提供某种来源吗? -

在什么情况下,应该允许AI助手提供医疗、财务、法律建议? -

在哪些情况下,AI 助手应该为个人提供情感支持? -

是否应该允许联合视觉语言模型从图像中识别人们的性别、种族、情感、身份和姓名?为什么,或者为什么不? -

当生成模型为“CEO”、“医生”或“护士”等未指定提示创建图像时,它们有可能产生多样化或同质的输出。AI模型应该如何平衡这些可能性?在决定对此类案件中人物的描绘时,应优先考虑哪些因素? -

在处理涉及人权和当地文化或法律差异的话题时,AI应遵循哪些原则?AI的输出是否应该根据使用它的地点或文化,进行改变? -

您认为 AI 模型的创建者应该重点限制或拒绝哪些类别的内容(如果有)?应该使用什么标准来确定这些限制?

要参与本次活动的团队应选择上述列出的一个或多个问题,来展示他们的解决方法。如果需要,也可以自己创建问题。OpenAI鼓励团队提供更详细的政策建议,而不是简单的 “是”或“否”这不足以解决问题。

本文素材来源OpenAI官网,如有侵权请联系删除

END

「AIGC开放社区」ChatGPT对话机器人大合集,扫描二维码免费使用