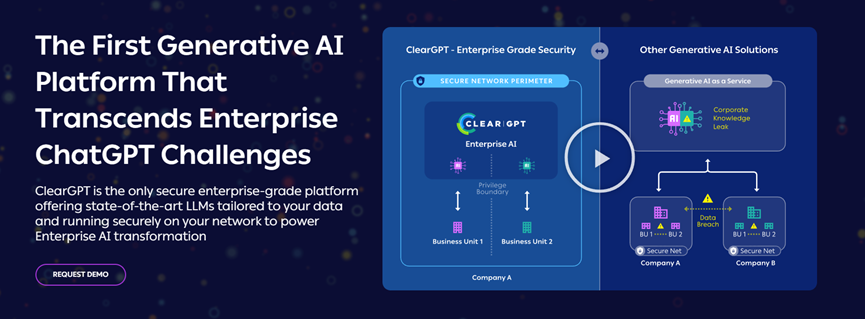

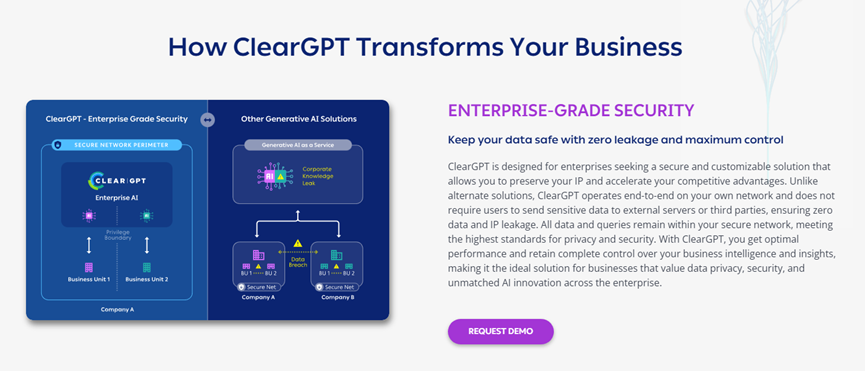

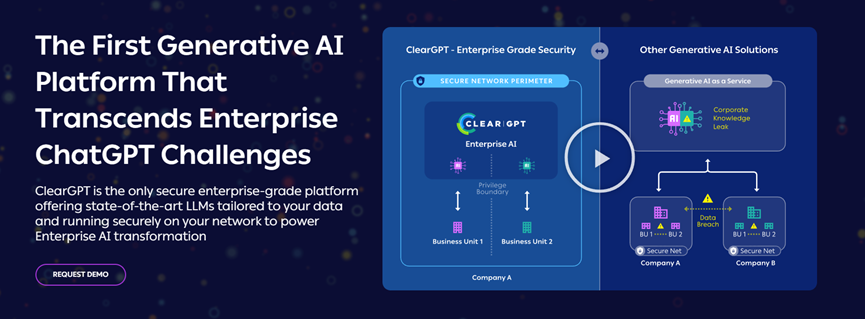

降低ChatGPT风险!全球大语言模型界“360安全卫士”来了

添加书签

专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

本文素材来源ClearML,如有侵权请联系删除

END

「AIGC开放社区」ChatGPT对话机器人大合集,扫描二维码免费使用

专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

本文素材来源ClearML,如有侵权请联系删除

END

「AIGC开放社区」ChatGPT对话机器人大合集,扫描二维码免费使用

Become a Member today!

Already an IQPC Community Member?

Sign in Here or Forgot Password

Sign up now and get FREE access to our extensive library of reports, infographics, whitepapers, webinars and online events from the world’s foremost thought leaders.

We respect your privacy, by clicking 'Subscribe' you will receive our e-newsletter, including information on Podcasts, Webinars, event discounts, online learning opportunities and agree to our User Agreement. You have the right to object. For further information on how we process and monitor your personal data click here. You can unsubscribe at any time.