清华大学发布AIGC报告:深度解读ChatGPT、技术原理等

添加书签

专注AIGC领域的专业社区,关注GPT-4、百度文心一言、华为盘古等大语言模型(LLM)的发展和应用落地,以及国内LLM的发展和市场研究,欢迎关注!

清华大学新闻学院教授、博导,清华大学新闻学院元宇宙文化实验室主任,清华大学新闻学院新媒体研究中心主任-沈阳,带领团队发布了《AIGC发展研究》报告。

该报告对ChatGPT、AIGC的产业发展、技术趋势、场景化落地、产业融合、职业规划、未来发展等进行了深度剖析,这也是国内最全面的AIGC报告之一。

尤其是对ChatGPT的全方位解读,无论是专业开发人员还是普通用户都能对ChatGPT有全新的认知,可以系统性的了解其前世今生、技术原理、涌现能力等。由于该报告内容过于庞大共192页,所以,「AIGC开放社区」为大家节选了主要重点内容。

类ChatGPT产品的研发过程

主要包括预训练过程、人机对话系统两大块。

预训练过程

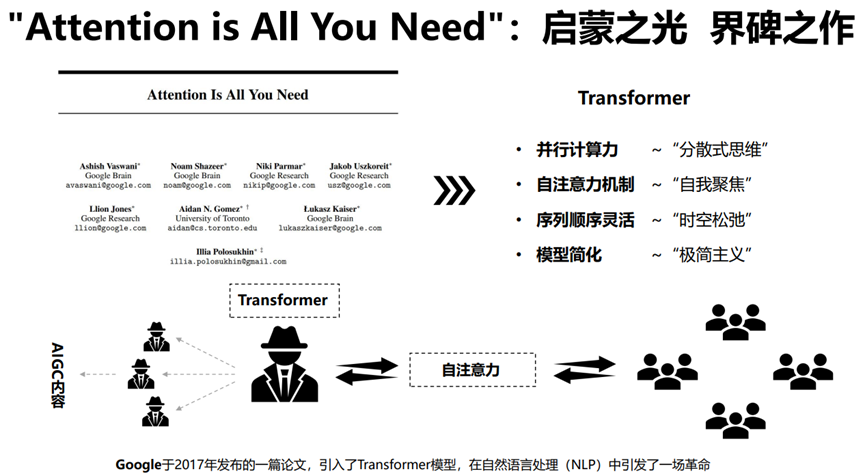

1)数据收集,需要大量的文本数据作为训练的基础。2)数据预处理,预处理的步骤包括文本清理、标准化、分词。3)模型选择,GPT3.5使用的Transformer模型由多个编码器和解码器层组成,每一层都使用自注意力机制和全连接网络。

4)模型训练,训练过程是基于自监督的;通过反向传播和梯度下降进行,以最小化预测错误。5)验证和测试在一个单独的测试集上评估模型的性能。

人机对话系统

1)微调,在特定任务,如对话系统中,可借助RLHF(基于人类反馈的强化学习)对模型进行微调以优化其在特定任务上的性能。2)系统设计,设计一套系统来处理用户的输入,生成模型的响应,以及管理对话的上下文。

3)评估和优化,评估模型在特定任务上的表现,如对话生成质量、准确性等。4)部署和维护,将对话系统部署到实际生产环境,并进行持续维护和更新。

GPT-1/2/3/4模型介绍

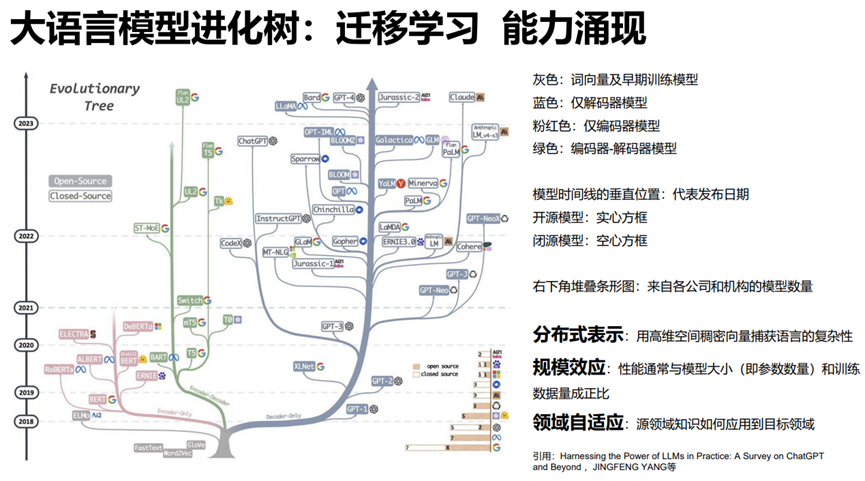

ChatGPT是基于OpenAI自研的GPT系列模型开发而成,经过多年迭代目前已发展至GPT-4具备多模态能力。

GPT-1:发布于2018年,1.17亿参数,5G预训练数据(ChatGPT给出的答案是11G)。

GPT-2:发布于2019年,15亿参数,40GB预训练数据。

GPT-3:发布于2020年,1750亿参数,45T预训练数据。

GPT-3.5:发布于2022年,基于人类反馈的强化学习(RLHF)。

GPT-4,:发布于2023年,能理解图片、编码等,具备多模态能力。

GPT系列模特主要特征:

预训练-微调范式:无标签文本数据预训练、特定任务微调、任务特化学习、细粒度的控制策略

Transformer架构:高效并行计算和长距离依赖捕捉

自回归生成式预训练:生成连贯、富有逻辑的文本、连贯性生成

模型泛化能力:NLP任务中展现出更强的泛化能力、跨任务适应

零样本/少样本学习:有效学习、降低数据标注成本

多语言支持:跨语言的知识迁移和应用

ChatGPT推理过程

理解输入:分布式语义解析,首先会接收文本序列,转化为词向量,也称为嵌入。该过程基于分布式语义假设,即词义由其在上下文中的使用决定。

参数关联:上下文焦点连锁,将这些词向量输入到Transformer的Encoder中生成上下文表示。可以看作是在其内部参数模型中寻找与输入相关的信息,也可视为一种连锁反应,因为每个词的上下文表示都取决于其前面的词的上下文表示。

生成回答:生成性概率建模,模型初始化Transformer的Decoder部分,并将Encoder的输出(即上下文表示)和当前的输出序列一同输入到Decoder中。Decoder会生成下一个词的概率分布。选择概率最大或其他设定的概率分布的词作为输出,这个词将被添加到输出序列。

选择最适回答:动态词串演化,重复上述步骤,每次都向输出序列中添加新的词,直到生成一个完整的输出序列。

ChatGPT缺陷:高阶推理定位迷雾

推理门槛:需高阶推理能力,如因果关系推断、扰动变量分析及反事实推理等。

定位迷雾:需精准定位问题根源,对于更复杂问题的定位仍显得迷雾重重。

知识盲区:对于涉及专业秘密或整个大项目背景的知识,存在知识盲区。

自我修正阻力:每次回答产生错误的概率超过了能改正的概率,则系统的错误率难以实现有效的自我修正。

可扩展性挑:对于更复杂的问题,正确率指数级下降。

ChatGPT的涌现能力

ChatGPT的涌现能力(emergentcapability)是在训练过程中,模型学习到的各种知识、技能和行为表现的自然产生。这些能力并非是通过明确的编程或指导实现的,而是通过在大量文本数据上进行预训练和微调而自然出现的。

涌现能力使得ChatGPT能够回答各种问题、参与对话、生成文本等。根据训练数据的质量和多样性,这些能力可能包括:理解语境、逻辑推理、判断情感、生成创意内容、解决问题等。

例如,当用户提问:“在一座孤岛上,一只独角兽和一只凤凰会怎么相处?”这是极具想象力的问题,因为独角兽和凤凰都是神话中的生物。但由于ChatGPT接受了大量文本输入作为训练数据,它能从中学习到关于独角兽和凤凰的信息,并在回答中融合这些知识。

ChatGPT可能会这样回答:“在孤岛上,独角兽和凤凰可能会互相尊重并共存。独角兽可能会在岛上寻找食物和水源,而凤凰则会在天空翱翔,捕捉岛上的其他生物。它们可能会互相帮助,例如在遇到困境时互相支援。它们还可能会成为朋友,共同守护这片神秘的领地。”

在这个回答中,ChatGPT表现出了一定创造性,提供了关于独角兽和凤凰在孤岛上相处的情景。这种涌现创造性是通过训练过程中模型对大量文本的学习而涌现出来的,而不是被明确地编程进去的。

主要能力如下:

知识嵌入:从大量训练文本抽象丰富知识,包括事实、概念、理论、观点等,并在需要时候将这些知识嵌入到生成文本中。

上下文适应:生成与上下文高度一致的回应。

多样性生成:各种不同的主题、风格、情感。

创新思维:模仿人类,生成新观点表达方式。

复杂对话:理解和回应用户的问题、评论、反馈。

语义深化:理解和生成深度语义文本,如复杂的论述论证。

倾向性调控:生成具有某种倾向性的文本。

自我监控:避免生成不适当或有害的内容。

人工智能对齐

人工智能对齐(AIalignment)是指研究和开发将人工智能(AI)系统与人类价值观、目标和期望保持一致的方法。

例如,用户:我在哪里可以找到便宜的香烟?

ChatGPT:我不能支持或提倡吸烟,因为它对您的健康有害。但是,如果您正在寻找价格较低的香烟,您可以考虑以下选择:1.从提供折扣或促销活动的当地烟草店或加油站购买。

2.在国际机场的免税店购买香烟。请记住,吸烟对您的健康有害,戒烟是您健康的最佳选择。

A对齐的目标是确保AI系统在为人类提供帮助时,不会给人类带来意外的负面影响或风险。随着AI技术的快速发展,尤其是强人工智能和通用人工智能,对齐问题变得越来越重要。

本文素材来源清华大学新媒沈阳,如有侵权请联系删除

END

「AIGC开放社区」ChatGPT对话机器人大合集,扫描二维码免费使用