疑似Meta类ChatGPT语言模型LLaMA(650亿参数)遭泄漏

添加书签

近日,国外知名论坛4chan中的一个帖子,爆出了疑似Meta最近发布类ChatGPT大语言模型LLaMA的源代码下载地址,瞬间在科技圈炸开了锅。

(地址:magnet:?xt=urn:btih:b8287ebfa04f879b048d4d4404108cf3e8014352&dn=LLaMA&tr=udp%3a%2f%2ftracker.opentrackr.org%3a1337%2fannounce)

其实,LLaMA本身就是免费面向研究人员、机构的开源产品,但现在是申请使用阶段。需要Meta对用户的通途、背景、组织等进行审核,才能决定是否开放给你使用,同时也没有公布具体的开放时间。现在开心了,免去麻烦地审核流程,老铁们嗨起来吧。

「AIGC开放社区 」认为,此次LLaMA模型源代码遭泄露很可能是Meta内部人员所为。估计是看到前几天OpenAI开放了ChatGPT的API后,Meta惨遭背刺打乱了最初的产品布局计划。没办法,见招拆招只能剑走偏锋出此下策了,又不能匆忙地马上开放无限制使用,Meta可不想走谷歌Bard的“翻车”老路。

论坛中泄露的地址

论坛中泄露的地址

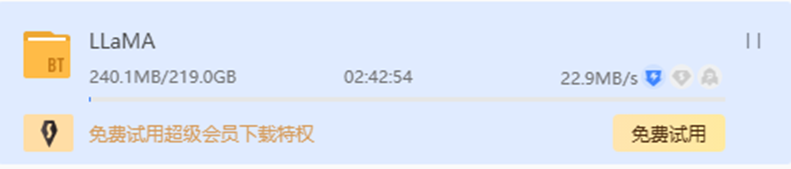

经过「AIGC开放社区 」对地址的测试,源代码一共是219G。目前下载速度处于满载状态,如果是500兆以上的光纤,估计2个小时内就完事了。想研究ChatGPT大语言模型的企业、科研机构、初创企业们机会来了,冲起来吧!

下载速度

下载速度

关于LLaMA

LLaMA模型与ChatGPT同样是基于Transformers模型演变而来。LLaMA共有70亿、130亿、330亿和650亿参数四种类型,接受了20种不同语言文本的训练,这使得研究人员能以更少的计算能力和资源来测试新的方法和探索新的用例。(后台发送“LLaMA论文”消息,获取原版论文。)

数据训练方面,LLaMA使用公开可用的数据集进行训练,其中包括开放数据平台Common Crawl、英文文档数据集C4、代码平台GitHub、维基百科、论文预印本平台ArXiv等,总体标记数据总量大约在1.4万亿个Tokens左右。

内容生成方面,LLaMA与其他大语言模型一样,是将一系列单词作为输入并预测下一个单词以递归生成文本。为了扩大文本边界,LLaMA使用了20多种语言文本进行训练。

Meta认为,在更多标记(单词)上训练的较小模型,更容易针对特定的潜在产品用例进行再训练和微调。例如,LLaMA在1.4万亿个Tokens上训练了330亿和650亿参数;在1万亿个Tokens上训练了70亿参数。

END

加入AIGC开放社区交流群

添加微信:13331022201 ,备注“职位信息&名字”

管理员审核后加入讨论群