性能比肩GPT-3.5,大幅度降低训练费用,斯坦福开源Alpaca模型

添加书签

3月14日,斯坦福大学研究中心宣布开源了,类Open AI的GPT-3.5大语言模型Alpaca。(开源地址:https://github.com/tatsu-lab/stanford_alpaca)

Alpaca是从Meta的LLaMA模型70亿参数中微调而成。Alpaca的行为类似于OpenAI 的GPT-3.5(text-davinci-003),并且在运行环境和训练费用方面更低。(在线体验地址:https://alpaca-ai-custom4.ngrok.io/)

斯坦福强调,Alpaca仅用于学术研究,不能用于任何商业用途。主要有3个原因:

1、Alpaca基于LLaMA模型演变而来,有非商业化规定;

2、训练数据基于OpenAI的text-davinci-003,有条款规定禁止开发与 Open AI竞争的模型;

3、开发团队还没有做好足够的安全措施,将Alpaca用于具体的业务场景。

为什么开源Alpaca

随着ChatGPT在全球范围内火爆出圈,其易用性、拟人化、高效率等特点受到了各行业的青睐,并被应用在不同的业务场景中,例如,微软将其与Bing搜索引擎相结合使用,使得月活用户突破1亿大关。

尽管ChatGPT展现出了无所不能的一面,但在模型、数据训练方面仍有缺陷,例如,会生成虚假信息,歧视信息等。为了解决这些难题,则需要学术研究机构的共同参与,但没有找到合适的开源模型用于研究。

直到Meta将LLaMA开源,斯坦福研究团队从70亿参数版本中微调了Alpaca模型并将其开源,同时提供了一个在线体验平台,让学术界更好地了解Alpaca的行为。通过与Alpaca的数据交互,这对于开发团队评估模型至关重要。

Alpaca数据训练

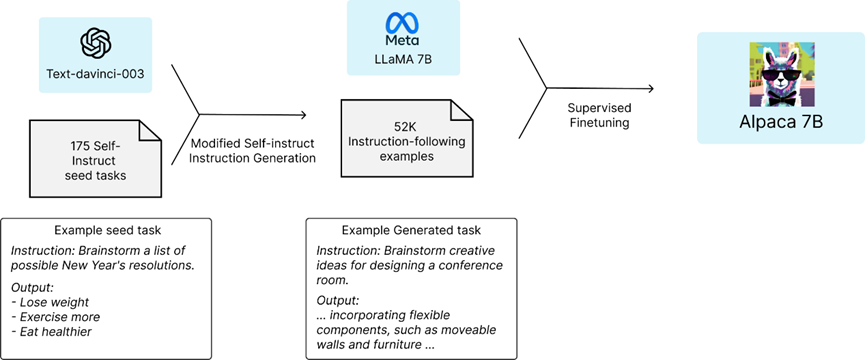

开发团队从text-davinci-003以自我指导方式生成了52K数据,用于训练Alpaca模型。对于数据,开发人员通过建立在“自我指导方法”的基础上生成了指令遵循演示。并从自我指导种子集中的,175个人工编写的指令输出对开始。

然后,提示 text-davinci-003使用种子集作为上下文示例生成更多指令。开发人员通过简化生成管道改进了自我指导方法,并显着降低了成本。在数据生成过程产生的52K条独特指令和相应的输出,通过 OpenAI API整个成本不到500美元。

配备了这个指令跟随数据集,然后开发团队通过Hugging Face 的训练框架微调 了LLaMA 模型,利用完全分片数据并行和混合精度训练等技术。

在8个80GB A100上微调一个7B LLaMA模型需要 3 个小时,这对大多数云计算提供商来说成本不到100美元。

Alpaca使用体验

开发团队表示,Alpaca的回答行为和text-davinci-003非常类似,可以用于生成电子邮件、营销内容等。通过在线体验地址,「AIGC开放社区」问了两个Alpaca问题,但得到的结果不太理想。

第一个问题:那支球队赢得了NBA 2019赛季总冠军?

Alpaca:洛杉矶湖人队赢得了2019年总冠军。

真实答案:多伦多猛龙队赢得了2019年总冠军。

随后,连续问了2021、2022赛季哪支球队赢得了总冠军,Alpaca的回答皆是湖人。看来Alpaca是湖人的铁粉,可惜答案都是错的。

第一个问题

第一个问题

第二个问题:梅西拿过世界杯吗?

Alpaca回答:梅西没有赢得世界杯。但他已经赢得了欧洲冠军联赛和其他几个主要冠军,但世界杯仍然遥遥无期。梅西目前是阿根廷国家队的一员,他们还没有赢得世界杯冠军。

真实答案:梅西拿到了世界杯。

第二个问题

第二个问题

不知是训练数据不足原因还是算法问题,Alpaca很多其他的回答不够准确。而开发团队也指出,目前Alpaca确实存在很多问题,例如,生成虚假信息,回答内容带有歧视性等,正在逐步完善功能。

未来,开发团队将公布两项研究成果。模型权重,已联系Meta获得发布Alpaca模型权重的指导,包括70亿参数和较大的LLaMA模型的微调版本。训练代码,截至目前代码使用LLaMA 的Huggin Face接口,但不是很稳定。一旦Hugging Face正式支持LLaMA,开发团队将给出准确的训练命令。

END

加入AIGC开放社区交流群

添加微信:13331022201 ,备注“职位信息&名字”

管理员审核后加入讨论群